Gemeinsam entwickeln wir nachhaltige Data-Lösungen.

Data Engineering

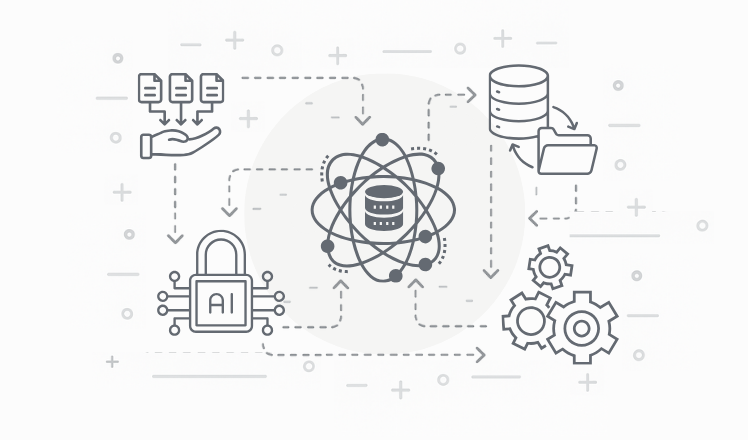

Data Engineering bezeichnet den Aufbau und die Wartung von Dateninfrastrukturen, die eine zuverlässige und effiziente Nutzung von Daten ermöglichen. Data Engineering stellt die technische Grundlage für fortgeschrittene Datenanwendungen wie Business Intelligence, KI und Machine Learning dar. Ohne belastbare Dateninfrastruktur ist kein datenbasiertes Arbeiten möglich.

Ein zentrales Ziel ist die Entwicklung automatisierter, robuster Datenpipelines. Diese sorgen dafür, dass Daten regelmäßig, konsistent und reproduzierbar verarbeitet werden – eine Voraussetzung für skalierbare und nachhaltige Datenlösungen.